關鍵戰力》加速運算、超級電腦、雲端巨頭…都靠它的產品

A100、H100、DGX、CUDA……,伴隨輝達股價創下歷史新高,一連串指涉其產品與技術的名詞近日屢屢躍上媒體版面,究竟這些名詞代表什麼意涵?

撰文‧黃煒軒

股價狂飆、題材熱炒,但國內外各項報告裡,關於輝達AI產品的專業術語一籮筐,你真的看懂其中門道嗎?以下,是近期輝達在公開場合中最常提到的關鍵字;看懂這些名詞,你才能深刻掌握AI王者的真實力。

DGX》 幫企業加速運算的AI伺服器

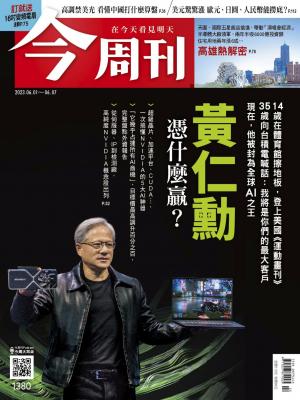

「過去四年,全世界安裝了價值一兆美元的資料中心設施,但它們完全是基於CPU(中央處理器)架構,不具有加速運算能力。未來,資料中心的預算將非常顯著地轉向加速計算。」在五月二十四日的財務說明會中,輝達創辦人暨執行長黃仁勳如此表示。

由此可見,輝達之所以對未來展望的一片樂觀,關鍵之一,就是因為認定企業將大幅提高「加速運算」的支出。而在這場說明會中被黃仁勳提到六次、被輝達其他主管提到七次的DGX,就是輝達提供的一種「加速運算平台」,或者說,是整合各種相關軟硬體的AI系統,更白話的說法,就是AI伺服器。

輝達目前有多種加速運算平台產品,如專為電動車開發的AGX、可搭配邊緣運算的EGX等;至於DGX,官方定位,是「為大規模企業AI基礎架構」提供的解決方案。

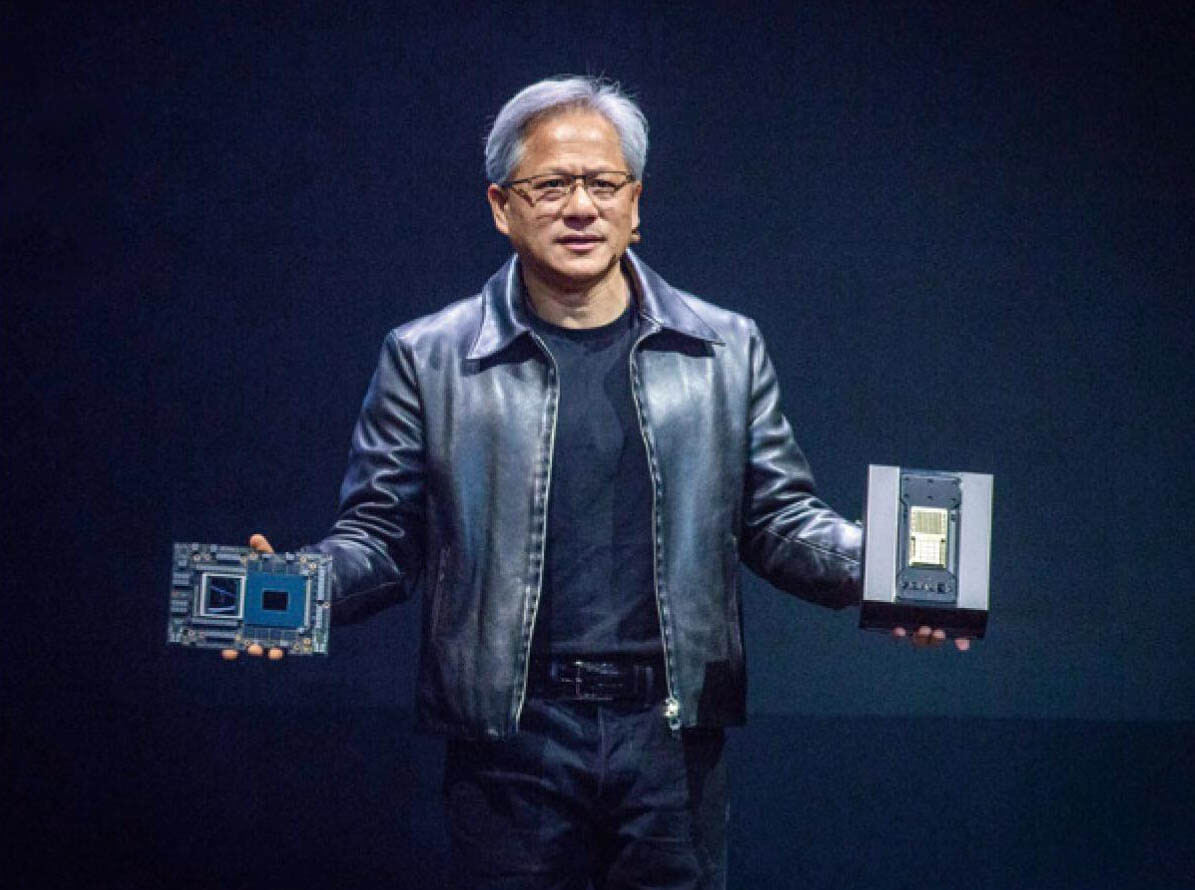

▲在日前的台北國際電腦展上,輝達創辦人暨執行長黃仁勳宣布,Grace Hopper超級晶片正式投產。攝影·蕭芃凱

今年八月起禁售中國的GPU

在五月二十九日伺服器代工廠緯穎的股東會上,公司表示,最快今年底或明年初,緯穎將開始出貨輝達A100產品。於是,雖然這個關鍵字在輝達的財報說明會中未被提及,仍值得多加認識。

所謂A100,是輝達在二○二○年五月發表的GPU,算是上一代的旗艦晶片,採用台積電七奈米製程。將這顆GPU裝進DGX裡, 就成了輝達的DGX A100伺服器;每台裝八顆,上市時一台要價十九.九萬美元。輝達曾舉例,若要打造一座現代化AI資料中心,只須在一個伺服器機櫃裡,裝進五台DGX A100,就能達標。

▲DGX A100

這款GPU已被美國下令自今年八月起禁售中國,為此,輝達也專為中國開發了降級版的A800產品,算力相同,但傳輸效能僅不到原先的七成,被認為僅能支應小型AI模型的開發。

H100》 微軟、Google、甲骨文都採用

相較於A100,輝達於二二年三月推出的H100,就是這回財報說明會中的主角之一了。這顆GPU據聞採用台積電四奈米製程,發表當時,黃仁勳稱「只要二十個H100,將可以維持全世界網路流量。」

那麼,為何這款去年三月發表的晶片,到了今年五月還是主角?因為,每台裝有八顆H100的DGX H100,是在今年五月正式出貨。在財報發表會中,黃仁勳特別強調,已有多家雲端服務巨頭宣布在其平台提供H100設備,包括微軟的Azure、Google Cloud、甲骨文的OracleCloud Infrastructure預覽版,以及亞馬遜AWS即將推出的產品等。

美銀證券報告指出,DGX H100的單價將是前代DGX A100的三倍。據聞,目前輝達的H100系統有六成由鴻海代工,下半年代工比重則可能拉到九成。

超級晶片》 打造效能逾六倍超級電腦

在DGX H100規格表裡的「CPU」項目中,能看到輝達用上了英特爾的產品;但在剛剛發表的DGX GH200規格表中,沒有CPU項目,取而代之的,是一個前所未見的怪項目,叫做「CPUand GPU」,該項目對應的,是「NVIDIAGrace Hopper超級晶片」。

在五月二十九日的台北國際電腦展(COMPUTEX)上,黃仁勳正式發表DGX GH200, 並宣布「GPU、CPU混合架構的Grace Hopper超級晶片正式投產。」這款晶片是以安謀(Arm)架構設計,據聞採用台積電五奈米製程。

用上了超級晶片,DGX GH200也就被稱為超級電腦;有多超級?其內串連了三十二台機座,每座內含八顆超級晶片,總計二五六顆。在稍早的輝達財報說明會中,公司主管提到,近期英國布里斯托大學宣布,打造了一台基於輝達Grace系統的超級電腦,其效能超過先前超級電腦的六倍。

CUDA》建構AI開發強大生態系

至於○七年推出、近期常被國內外媒體提及的CUDA,全稱ComputeUnified Device Architecture,是輝達基於其生產的GPU,提供給開發人員的一套免費編程工具,最初是為了配合GeForce系列晶片而推出。

CUDA的最大優勢,在於其能相容許多高階的程式設計語言,開發人員得以利用CUDA的應用程式介面(API)進行「平行」程式設計與加速運算;此外,在CUDA強大的功能庫與完善的開發工具下,程式開發人員只需以幾個關鍵字,就能夠直接存取GPU的虛擬指令集和平行運算元素。

分析認為,CUDA的推出,相當程度降低了全球新創投入AI發展的門檻, 特別是在科學模擬或AI深度學習訓練等需要極高運算能力的領域,而伴隨全球愈來愈多企業使用CUDA的開發工具,CUDA逐漸長成了一個在AI開發領域幾乎無所不包、兼具軟硬體整合的「生態系」,也讓輝達得以在相關GPU的發展上,建構出一條深廣的護城河,為其後續的競爭優勢打下堅實基礎。

閱讀完整內容

本文摘錄自

五大神器 看懂輝達的AI力

今周刊

2023/6月 第1380期

相關

.jpg)