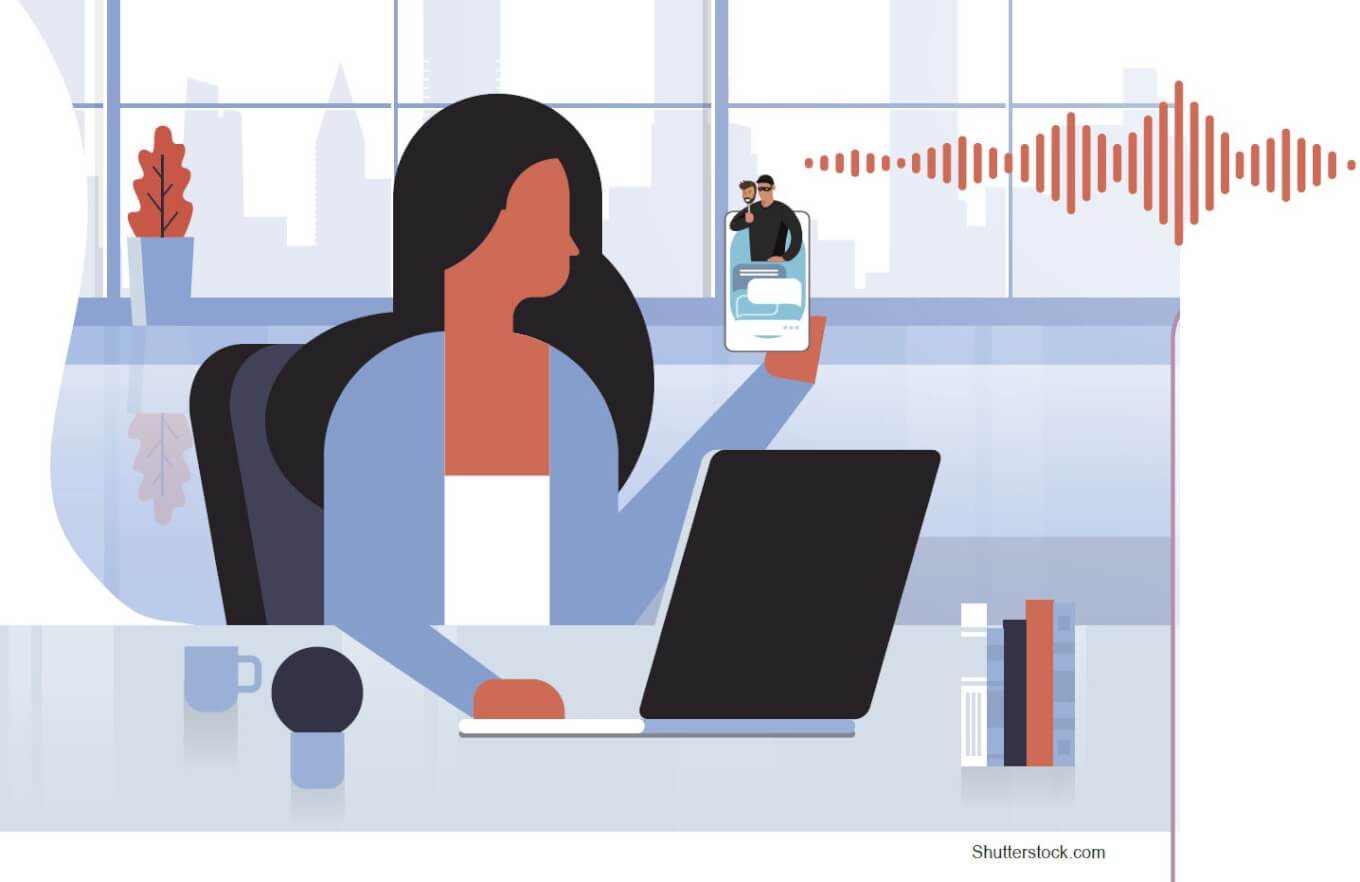

「假兒女」來電呼救,AI偽聲詐騙襲台

12秒就能複製你的聲音連親媽都聽不出真偽

上傳兩段6秒的原始音檔,就能模仿聲紋,本來是一種趣味遊戲,如今竟然成為新時代的詐騙工具。AI偽聲行騙無所不在,現在已充斥台灣各個角落,全民應該如何防範?

文/羅之盈

「媽!我被綁架了,趕快轉錢來!」這個行之有年的哭喊型電話詐騙,台灣人已經有所警覺,但如果你聽到的是自家子女的聲音呢?

藝人夫妻檔王仁甫、季芹,2023年底遇上最新型態「AI偽聲詐騙」,季芹接起手機來電,聽到「女兒」苦喊著:「媽媽妳現在要去哪裡?」、「媽媽我現在需要錢,妳可以轉錢給我嗎?」季芹覺得古怪,掛了電話後,立刻聯繫女兒樂樂,所幸女兒安然無恙,才知道原來電話那頭哭喊的是「AI假女兒」。

王仁甫向媒體透露,應該是遇到兩階段詐術:樂樂前幾天接到「市場調查的民意機構」電話,詢問「家住哪裡」等,要樂樂多說點話,收集聲紋之後透過AI生成聲音,偽聲進行詐騙。

AI加工詐騙增幅逾五成

科技趨勢媒體《麻省理工科技評論》(MIT Technology Review)2024年元月做出年度預測,認為AI(Artificial Intelligence,人工智慧)在2023年生成式AI應用得到突破之後,2024年能夠執行廣泛任務的機器人技術,將愈來愈成熟,也會有愈來愈多基於通用模型,衍生出來的新應用。

該份報告也提醒,生成式AI常為人詬病的「過度衍生」問題,亦即模型常會生成許多繁複或錯誤的資訊,仍待克服。此外,有心人士透過模型技術刻意捏造、偽造的假訊息、假圖片、假影音、假聲音,將會充斥人類社會。

防毒軟體McAfee去年中進行全球調查,7000名受訪者之中,有10%曾遇過AI偽聲詐騙,而因為過於真實、無法辨識,其中77%甚至因此損失錢財!

美國聯邦貿易委員會(FTC)發出警訊,不法人士蒐集大眾生物識別資訊,透過AI技術加工詐騙的事件,過去一年與前期相比增幅超過五成。美國聯邦貿易委員會有鑑於此,並在2024年元月,以2.5萬美元「懸賞」反制AI偽聲詐騙的技術,以遏止愈來愈失控的犯罪事件。

警政署預防科科長林書立觀察,自ChatGPT引爆生成式AI以來,影音、文字、圖像類的AI技術也隨著加速進步,成為犯罪集團運用的主力,尤其是聲音偽造。

他指出,AI偽聲詐騙從去年第一季在美國開始蔓延,快速滲透至英語系國家,生成式AI本來就有跨語言特色,於是慢慢擴展到多個國家,2023年第四季開始,中國陸續將此類AI工具的使用介面中文化,讓偽聲生成「更便利」,快速擴散至台灣社會。

難道得用「AI防制AI」?

「技術本身沒有善惡,重點仍是怎麼使用它,」陽明交通大學電機工程系副教授游家牧分析,擬聲技術最早是為了視障者而開始的學術研究,原本是文本轉語音,經過多年的語調優化推進,讓電腦合成語音,愈來愈能掌握音調、音色等特徵,聽起來愈來愈自然擬真,常見的銀行自動語音客服、AI語音圖書朗讀等,都是這類技術的運用。

另外AI生成技術,在2016年機器學習「優化理論」之後,得到巨大推進,這也就是ChatGPT的技術基礎。當時被圖像學相關的AI愛好者,開發出深度偽造技術(Deepfake)用於人像照片換臉,後來一路演進到聲音領域,搭配過去電腦合成語音技術基礎,讓深度偽聲技術(Deepvoice)得以模仿特定個人的音色,推論出平順的連續性語調。

「現在只要上傳很短的音檔,就可以生成聲音,目前看到最少只需要2段6秒原始音檔就可以了,上傳音檔愈多就愈逼真,」游家牧表示。

12秒音檔就能複製另一個我?而且是一個親媽都難以分辨的聲音,民眾該如何是好,難道真的得用「AI防制AI」?

2023年11月美國學者發布了反偽聲的AntiFake,原理是稍微扭曲或擾動原始音檔,加入人類聽不到的細小雜訊,讓音檔無法用於AI模型。

游家牧認為,「AI防制AI的確有可能成功,但實用性還很難說,」因為防制AI技術的「Adversarial Attacks」還在學術界的理論階段,究竟要加入多少雜訊,才能既不影響人類辨識,又能防制模型解讀,需要現實世界實測;更麻煩的是,各大模型都不相同,防制了A模型,可能防制不了B模型,「我們最終不知道詐騙集團採用了哪一個模型,或是用了多少種模型。」

真的擬聲、假的偽聲難分辨

同時是數位發展部AI防詐顧問的游家牧,本身在元月也遇到AI偽聲詐騙。

游媽媽先接到偽裝成游家牧的電話,說自己手機壞了,要媽媽先刪除自己的電話號碼、LINE等聯絡方式,隔幾天又接到假的游家牧來電,說需要錢,要媽媽轉帳。

游媽媽先是問聲音怎麼有點怪怪的?對方答:感冒了。游媽媽又問以往商量好的「通關密語」,對方答不上,於是游媽媽立刻掛掉電話,但又已刪除兒子的聯絡方式,輾轉聯繫上兒媳,才確認當時在國外的游家牧一切平安。

「我們都算有警覺的人,還是有點緊張,一般人就更不用說了,」游家牧語氣中盡是無奈。

在詐術演進上,AI偽聲詐騙與以往冒名詐騙有兩大差異,一是其為指定對象的針對性詐騙,二是未來將是善意的擬聲,與惡意的偽聲,同時共存的世界。真真假假同時運行,讓辨識更為困難。

AI偽聲詐騙需要先找到指定對象的親友,騙出其聲音,再模仿聲紋施行詐術,跟以往冒名詐騙是亂槍打鳥、不知接電話的人是誰,有很大不同。

問題是,詐騙集團如何鎖定詐騙對象?並進一步客製化聲紋?

警政署表示,這類精準詐騙攻擊,以國外經驗來看,對象名單來源有二,一是透過假冒進行問卷等釣魚手段,逐步搜集;二是盜取公務或私人企業的客戶個人資料。前者防不勝防,後者則需要網路資訊安全架構的強化,並強化員工防護資安與營業祕密的素養。

一位白帽駭客(尋找資安漏洞,但不進行攻擊的軟體工程師)觀察,在隱藏網路位置的「暗網」交易平台,流傳許多台灣公私部門流出的個人資料,常見的有如購物網站訂單紀錄、企業的員工資料庫,甚至有疑似戶政資料的大批個資販售,這些可以重複販售的個資,讓詐騙集團有機會精準攻擊特定對象。

此外,AI偽聲詐騙雖是不法人士的勾當,AI擬聲卻是時代新潮流。例如台灣歌手陳珊妮,去年推出新單曲《教我如何做你的愛人》,歌聲充滿個人特色,情感豐沛,但其實不是她本人唱的,而是她與AI Lab合作的AI擬聲。又如美國紐約市長亞當斯( Eric Adams)創建個人AI語音模型,讓他可以用多種語言向市民發送訊息,包括西班牙語、華語等。

因此,AI擬聲這樣的中性技術,同時在善惡領域融入人類社會,真的擬聲、假的偽聲,都正在不分日夜快速生成中。

設「通關密語」是不二法門

「眼見不為真,耳聽不為實,是面對陌生來源的遠端訊息,該有的警覺!」林書立建議,親友之間要設立「通關密語」,選擇不會出現在任何資料庫的生活細節,做為辨認真偽的關鍵,例如小學導師的姓名、社區收垃圾的時間等,以此設立防詐的層層關卡。

AI已經無所不在,帶動的社會變遷勢不可擋,建立自我防範意識才是解方。

5招防AI偽聲詐騙

1.平時預防演練:事前與親友約定「通關密語」,或是詢問生活細節,以確認對方身分。

2.不明來電,提高警覺:詐騙集團會聲稱換過手機號碼或LINE ID,讓來電來源和以往不同。

3.冷靜,別被急迫引導:詐騙集團會以車禍、開刀等緊急用錢理由,請求短時間內匯款,請務必慢下來,讓自己有時間思考。

4.尋找破綻:質疑對方電話中聲音與以往不一樣時,詐騙集團常以感冒、喉嚨不適、被打等理由,來取得信任。

5.自行撥去確認:不論誰的聲音打過來,建議先掛斷,自行撥打給被冒名者確認,或是向其他親友確認。

資料來源:警政署 整理:羅之盈

閱讀完整內容

本文摘錄自

12秒就能複製你的聲音 連親媽都聽不出真偽

遠見雜誌

2024/2月 第452期

相關